Probabilmente possiedi già un computer AI.

Negli ultimi mesi, i produttori di PC e Intel hanno battuto a gran voce il tamburo per i PC AI e di concerto con AMD, Intel e Qualcomm. Non è un segreto che l’intelligenza artificiale sia la nuova “trasformazione” e sia i dirigenti che gli investitori vogliono utilizzare l’intelligenza artificiale per aumentare le vendite e i prezzi delle azioni.

È vero che l'intelligenza artificiale si basa sulle NPU presenti in chip come Core Ultra di Intel, un marchio che Intel posiziona come sinonimo di intelligenza artificiale su chip. Lo stesso vale per la serie Ryzen 8000 di AMD, che batte Intel nell'utilizzo della NPU desktop, e per lo Snapdragon di Qualcomm.

È solo che le NPU integrate nel Core Ultra al momento (Meteor Lake, ma con Lunar Lake in attesa dietro le quinte) non giocano un ruolo importante nel calcolo dell'IA su cui sono posizionate. Invece, i ruoli più tradizionali della potenza computazionale (CPU e soprattutto GPU) contribuiscono maggiormente al compito.

È importante notare diverse cose: in primo luogo, misurare le prestazioni dell’intelligenza artificiale è in realtà qualcosa con cui tutti sono alle prese. L’“intelligenza artificiale” consiste in compiti alquanto disparati: generazione di immagini, come l’utilizzo della diffusione; Large Language Models (LLM), chatbot resi famosi da Microsoft Copilot e Google Bard (basati su cloud); E una serie di miglioramenti specifici dell'app, come i miglioramenti dell'intelligenza artificiale in Adobe Premiere e Lightroom. Combina le numerose variabili presenti solo nei LLM (framework, modelli e quantizzazione, che influiscono tutti sul modo in cui i chatbot funzionano su PC) un passo Queste variabili fluttuano ed è molto difficile scegliere un vincitore – e per più di un momento nel tempo.

Tuttavia, il punto successivo è quello che possiamo affermare con una certa certezza: il benchmarking funziona meglio quando si rimuovono quante più variabili possibile. Ed ecco cosa possiamo fare con un piccolo pezzo del puzzle: quanto CPU, GPU e NPU di Intel contribuiscono ai calcoli AI eseguiti dal chip Meteor Lake di Intel Core Ultra.

Mark Hashman/IDG

Al momento la NPU non è il motore AI on-chip. L'unità di elaborazione grafica è

Non stiamo cercando di determinare le prestazioni di Meteor Lake nell'intelligenza artificiale. Ma quello che possiamo fare è verificare con la realtà quanto sia importante la NPU nell’intelligenza artificiale.

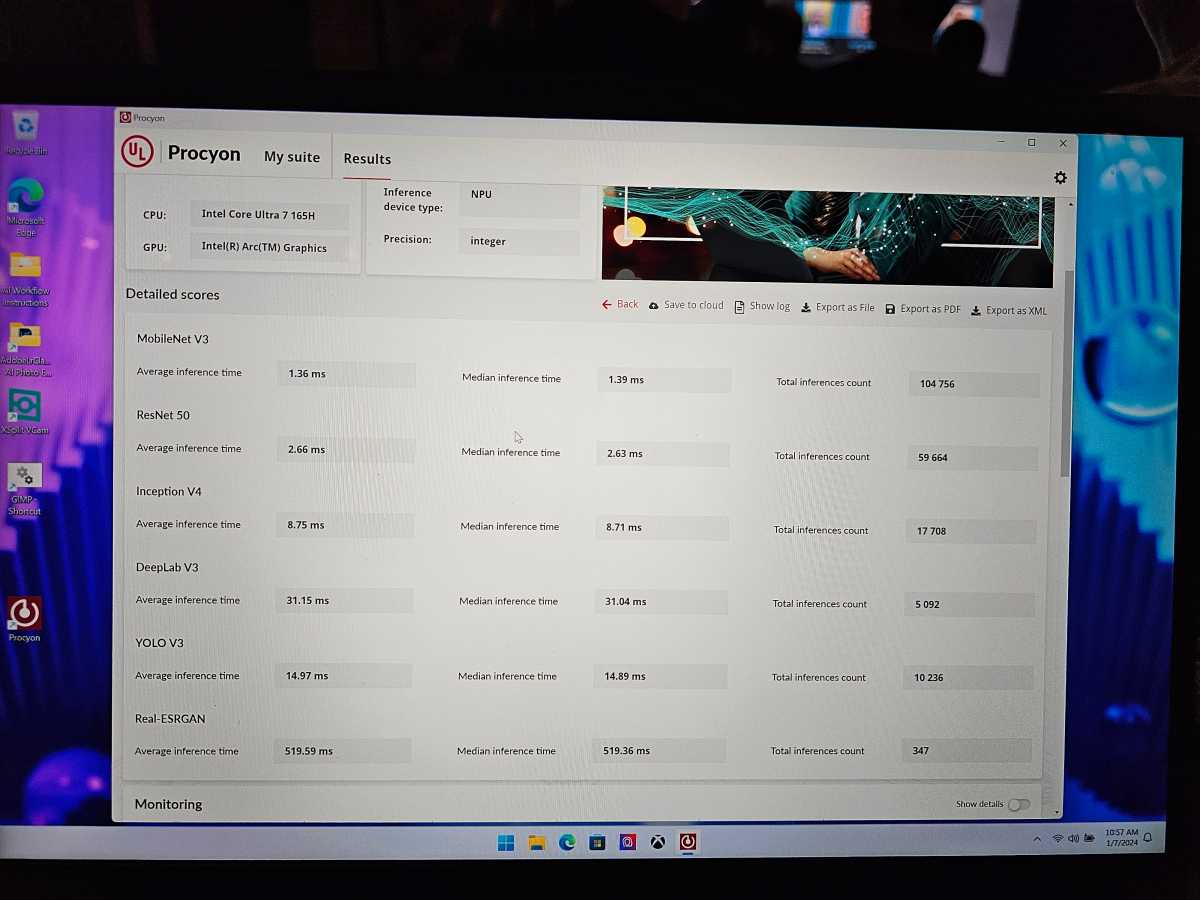

Il test specifico che utilizziamo è il benchmark di inferenza AI Procyon di UL, che calcola l'efficienza di funzionamento di un processore quando ha a che fare con molti modelli linguistici di grandi dimensioni. Nello specifico, consente al tester di scomporlo, confrontando l'unità di elaborazione centrale (CPU), l'unità di elaborazione grafica (GPU) e l'unità di elaborazione neurale (NPU).

In questo caso, abbiamo testato il Core Ultra 7 165H all'interno di un laptop MSI, che è stato reso disponibile per i test durante la giornata di benchmark di Intel al CES 2024. (Ho passato la maggior parte del mio tempo a intervistare Dan Rogers di Intel, ma sono riuscito ad alcuni test in .) Procyon esegue LLM sul processore e calcola il punteggio in base a prestazioni, latenza, ecc.

Senza ulteriori indugi, ecco i numeri:

- Procione (OpenVINO) NPU: 356

- GPU Procione (OpenVINO): 552

- Processione (OpenVINO): CPU: 196

I test Procyon hanno dimostrato diversi punti: in primo luogo, la NPU fa la differenza; Rispetto ai core di prestazioni ed efficienza presenti in altre parti della CPU, la NPU li supera dell'82%, tutto da sola. Ma le prestazioni AI della GPU sono pari al 182% di quelle della CPU e superano quelle della NPU del 55%.

Mark Hashman/IDG

In altre parole: se apprezzi l’intelligenza artificiale, acquista prima una scheda grafica o una GPU di grandi dimensioni.

Ma il secondo punto è meno chiaro: sì, lo sei Potere Esegui applicazioni AI su una CPU o GPU, senza la necessità di un blocco logico AI dedicato. Tutti i test Procyon dimostrano che alcuni blocchi sono più efficaci di altri.

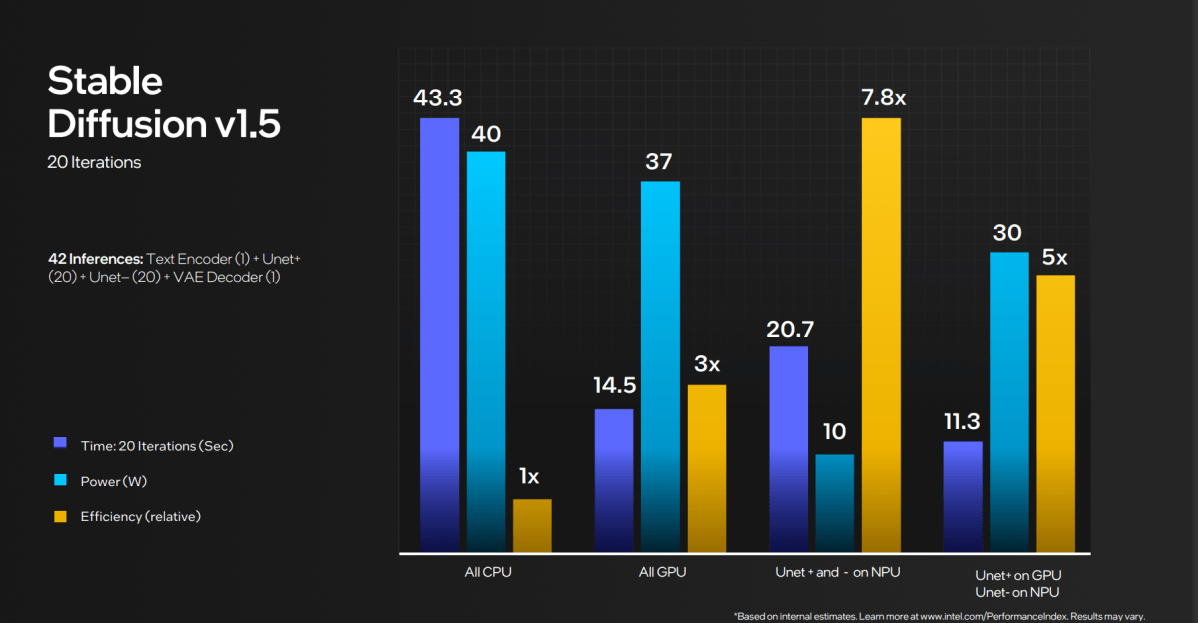

Cosa dice Intel (e per essere onesti, lui ha È stato detto) che la NPU è più efficiente. Nel mondo reale, “efficienza” è il codice del produttore di chip per “lunga durata della batteria”. Nel frattempo, Intel ha cercato di sottolineare che l'unità di elaborazione centrale (CPU), l'unità di elaborazione grafica (GPU) e l'unità di elaborazione neurale (NPU) possono lavorare insieme.

Intel Corporation

In questo caso, l'efficienza della NPU è equivalente alle applicazioni AI che funzionano nel tempo e possibilmente a batteria. Il miglior esempio di ciò è una lunga chiamata Microsoft Teams dal profondo di una camera d'albergo o di un centro conferenze (proprio come il CES!) in cui l'intelligenza artificiale viene utilizzata per filtrare il rumore e l'attività di sottofondo.

In genere, le applicazioni artistiche IA come Stable Diffusion vengono inizialmente rilasciate come un modo per creare opere artistiche IA locali utilizzando la potenza della GPU, insieme a una grande quantità di VRAM disponibile. Ma nel corso del tempo, le applicazioni di intelligenza artificiale si sono evolute per funzionare su configurazioni meno potenti, spesso includendo un’unità di elaborazione centrale (CPU). Questa è una metafora familiare. Non eseguirai un gioco ad alta intensità grafica come… crisi Va bene sui dispositivi embedded, ma deve funzionare molto, molto lentamente. Gli LLM/chatbot AI faranno lo stesso, “pensando” a lungo alle loro risposte e poi “scrivendole” molto lentamente. I corsi LLM che possono essere eseguiti su una GPU funzioneranno meglio e le soluzioni basate su cloud saranno molto più veloci.

Tuttavia, l’intelligenza artificiale si evolverà

È anche interessante che l'app Procyon di UL (al momento della stesura di questo articolo) riconosca la CPU e la GPU del Ryzen 7040 AMD Ryzen basato su AI, ma NO Unità NPU. Siamo agli albori dell’intelligenza artificiale, quando anche le capacità di base dei chip stessi non vengono riconosciute dalle applicazioni progettate per utilizzarli. Ciò non fa altro che complicare ulteriormente il test.

Tuttavia, il punto è che non hai bisogno di una NPU per eseguire l'intelligenza artificiale sul tuo PC, soprattutto se hai già un laptop o desktop da gioco. Sarebbe bello avere NPU di AMD, Intel e Qualcomm, ma non sono nemmeno necessarie.

Mark Hashman/IDG

Tuttavia, non sarà sempre così. Intel promette che la NPU nel prossimo chip Lunar Lake, previsto per il rilascio alla fine di quest'anno, avrà prestazioni tre volte superiori a quelle di una NPU. Non menziona nulla sulle prestazioni della CPU o della GPU. È molto probabile che nel tempo le prestazioni delle NPU nei diversi chip dei computer aumenteranno, tanto che le prestazioni dell’intelligenza artificiale diventeranno notevolmente sproporzionate rispetto ad altre parti del chip. In caso contrario, un gran numero di startup di chip acceleratori di intelligenza artificiale hanno in programma di diventare i 3Dfx del mondo dell’intelligenza artificiale.

Ma per ora, siamo qui per fare un respiro profondo all'inizio del 2024. I nuovi personal computer dotati di intelligenza artificiale sono importanti, ma lo sono anche le nuove unità di elaborazione neurale. Ma i consumatori probabilmente non saranno interessati quanto i produttori di chip a far funzionare l’intelligenza artificiale sui loro computer, piuttosto che sul cloud, non importa quanto forte sia l’hype. E per chi se ne preoccupa, la NPU è solo una parte della soluzione complessiva.

“Esploratore. Scrittore appassionato. Appassionato di Twitter. Organizzatore. Amico degli animali ovunque.”