Un team di ricercatori della Stanford University e di Google ha condotto un esperimento per studiare come i “generatori” potrebbero adattarsi a un ambiente virtuale interattivo “sandbox” ispirato al popolare gioco.

sims. Si scopre che questi agenti hanno finalmente adottato un comportamento relativamente vicino a quello degli umani.

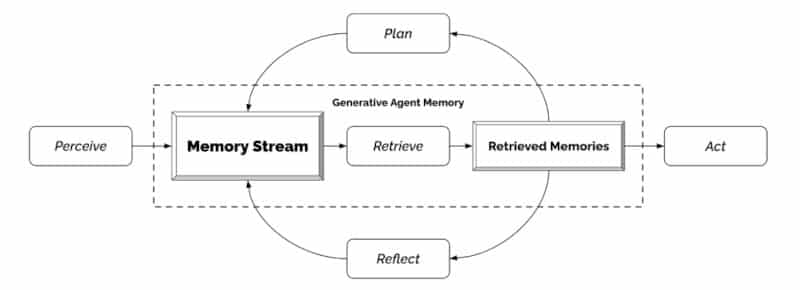

In questo esperimento, i ricercatori hanno addestrato 25 operatori generativi con identità diverse, utilizzando il modello di linguaggio esteso GPT-3.5 di OpenAI. Li introducono quindi in un’ipotetica cittadina, chiamata Smallville, composta da case, attività commerciali, un parco, una scuola, un pub e così via. ; Gli utenti finali possono interagire con loro utilizzando il linguaggio naturale. ” [Notre architecture] Espande un modello di linguaggio di grandi dimensioni per archiviare una registrazione completa delle esperienze di un agente utilizzando il linguaggio naturale, sintetizzare quei ricordi nel tempo in riflessi di livello superiore e recuperarli dinamicamente per mappare il comportamento Tipo ricercatori.

Alla fine, questi 25 avatar alimentati dall’intelligenza artificiale si sono comportati quasi come esseri umani. I ricercatori hanno già riferito di “comportamenti sociali individuali ed emergenti”. Ad esempio, sulla base di un indizio identificato dall’utente (che l’agente vuole organizzare una festa di San Valentino), gli agenti trasmettono in modo indipendente gli inviti alle feste nei due giorni successivi, invitandosi a vicenda alla festa e coordinando insieme la partecipazione a destra, il squadra ha detto.

Gli agenti sono in grado di adattarsi ai cambiamenti nel loro ambiente

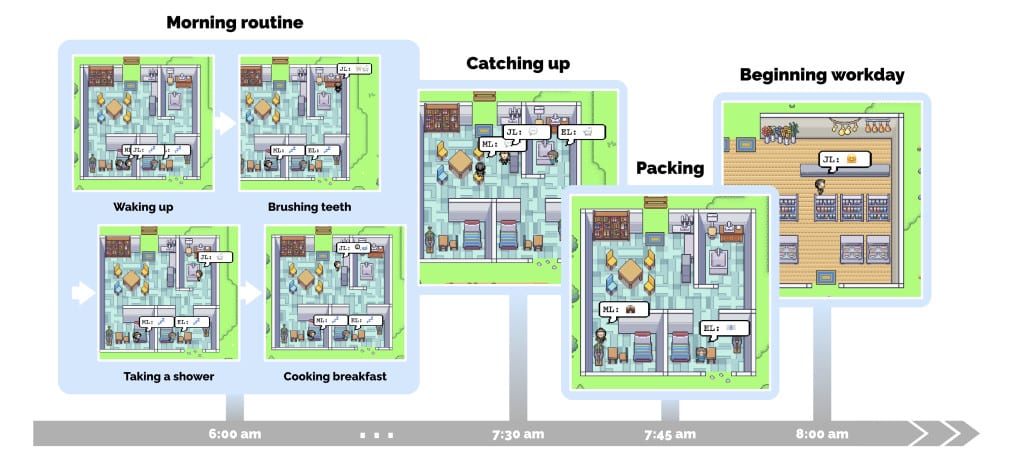

Per ciascuno degli agenti, i ricercatori hanno scritto un paragrafo in linguaggio naturale che descrive la loro identità, compresa la loro occupazione, i tratti della personalità e le relazioni con altri agenti, come base di memoria. Gli agenti generativi si sono adattati perfettamente al loro ambiente, simulando la vita quotidiana tipica e rispettando gli orari: alzarsi, preparare la colazione e lavorare. Ciascuno di loro svolge attività adeguate alla sua professione. Si notano a vicenda, iniziano conversazioni (comunicando in linguaggio naturale) e si formano persino opinioni.

Una mattina nella vita di un agente, John Lane. Si alza verso le 6 del mattino e svolge la sua routine mattutina. Parla brevemente con sua moglie, May, e suo figlio, Eddie, prima di partire per la giornata di lavoro. © JS Park et al.

In un esempio di interazione, i ricercatori hanno riferito uno scambio tra diversi membri della stessa “famiglia”, in cui il padre ha riassunto alla moglie lo scambio appena avvenuto con suo figlio. Altri due gettoni discutono delle imminenti elezioni in città. ” Ad essere onesto, non mi piace Sam Moore. Penso che sia disconnesso dalla società e non abbia a cuore i nostri migliori interessi ha detto un funzionario quando un altro ha chiesto la sua opinione sul candidato sindaco.

Gli utenti finali avevano la possibilità di rimodellare l’ambiente dell’agente riscrivendo lo stato delle cose intorno ad esso in linguaggio naturale. Ad esempio, quando al mattino un avatar di nome Isabella stava preparando la colazione, l’utente ha cambiato lo stato della stufa da “accesa” a “accesa” digitando l’apposito comando; Se ne accorse subito, Isabella spense i fornelli e si preparò di nuovo la colazione. Allo stesso modo, impostando lo stato della doccia di Isabella su “Perdita d’acqua” quando entra nella doccia, quest’ultima recupera gli strumenti e tenta di riparare la perdita.

Gli agenti hanno mostrato rapidamente comportamenti sociali emergenti: interagendo tra loro, hanno scambiato e diffuso informazioni, incontrato nuove persone e formato nuove relazioni; Sono stati anche in grado di riutilizzare le informazioni ottenute e coordinarsi attorno a determinate attività.

“Piccoli passi” verso l’intelligenza generale artificiale?

Il team spiega che quando un agente diventa consapevole del proprio ambiente, tutte le percezioni vengono memorizzate in un registro completo delle esperienze chiamato “flusso di memoria”. Sulla base di queste percezioni, l’architettura recupera i ricordi rilevanti e poi li utilizza per determinare l’azione. Questi ricordi sono anche usati per formare piani a lungo termine e per generare pensieri di livello superiore, che vengono immagazzinati nel flusso di memoria per un uso successivo.

Un diagramma dell’architettura alla base degli avatar intelligenti. © JS Park et al.

Vuoi rimuovere gli annunci dal sito

Pur continuando a sostenerci ?

È semplice, basta registrarsi!

Al momento, 20% di sconto Sull’abbonamento annuale!

” I componenti della nostra struttura di agenti – monitoraggio, pianificazione e ragionamento – contribuiscono in modo critico alla credibilità del suo comportamento. “, sottolineano gli autori.” Riteniamo che gli agenti generativi possano svolgere un ruolo in molte applicazioni interattive, dagli strumenti di progettazione ai sistemi di social computing e agli ambienti immersivi. hanno concluso.

Il modello, tuttavia, non era infallibile. I ricercatori hanno riferito che i clienti a volte abbelliscono la loro conoscenza con “allucinazioni” e che dimenticano certi eventi. Il team osserva inoltre che l’esperimento è stato condotto per un breve periodo (due giorni) e che sono necessarie ulteriori ricerche per esaminare il comportamento degli agenti per un periodo di tempo più lungo per comprendere appieno le loro capacità e limitazioni. Sarà inoltre necessario testare la sua forza contro gli attacchi di tipo Trucco rapido O Trucco della memoria.

Nel frattempo, questi risultati mostrano come il modello di intelligenza artificiale generativa alla base di ChatGPT possa essere utilizzato al di fuori della sua applicazione come assistente virtuale, ha detto a dall’interno Michael Woolridge, un professore di informatica all’Università di Oxford che studia l’intelligenza artificiale e non è stato coinvolto nello studio. Ha detto che l’esperimento è stato “piccoli passi” verso il raggiungimento di “intelligenza generale artificiale” – una fase ipotetica in cui gli strumenti di intelligenza artificiale sarebbero in grado di dimostrare comportamenti umani complessi, come la coscienza. Ma prima di raggiungere questo obiettivo, C’è ancora molta strada da fare “, Ha aggiunto.

fonte : JS Park et al., arXiv

“Pioniere del caffè a misura di hipster. Creatore amichevole. Analista pluripremiato. Scrittore. Studioso di cibo. Drogato di televisione. Ninja di Internet.”