Il presidente di Tinybuild, Alex Nichiporchik, afferma che l’azienda utilizza l’intelligenza artificiale per identificare i lavoratori tossici, che, secondo il CEO, includono anche coloro che stanno vivendo il burnout.

Nichiporchik mostra come l’azienda utilizza l’IA sul posto di lavoro durante lo sviluppo: il discorso di Brighton intitolato “AI in Gamedev: Is My Job Safe”, ha introdotto una sezione chiamata “AI for HR” e ha discusso di come la tecnologia può essere utilizzata per setacciare le comunicazioni dei dipendenti e identificare i lavoratori “problematici”.

In un estratto del talk pubblicato da Why Now GamingNichiporchik spiega come il ciao vicini L’editore inserisce il testo dei messaggi Slack, le trascrizioni automatiche da Google Meet e Zoom e i task manager utilizzati dall’azienda in ChatGPT per eseguire una “analisi me-and-me” che consente a Tinybuild di misurare “la probabilità che una persona vada in burnout .”

Nichiporchik ha affermato che la tecnologia, che afferma di aver inventato, è uno “strano specchio nero” e prevede l’utilizzo di ChatGPT per monitorare il numero di volte in cui i lavoratori hanno detto “me” o “me” nelle riunioni e in altra corrispondenza.

Perché? Perché afferma che esiste una “relazione diretta” tra la frequenza con cui qualcuno usa queste parole, rispetto alla quantità di parole che usa in generale, e la probabilità che proverà fatica in futuro.

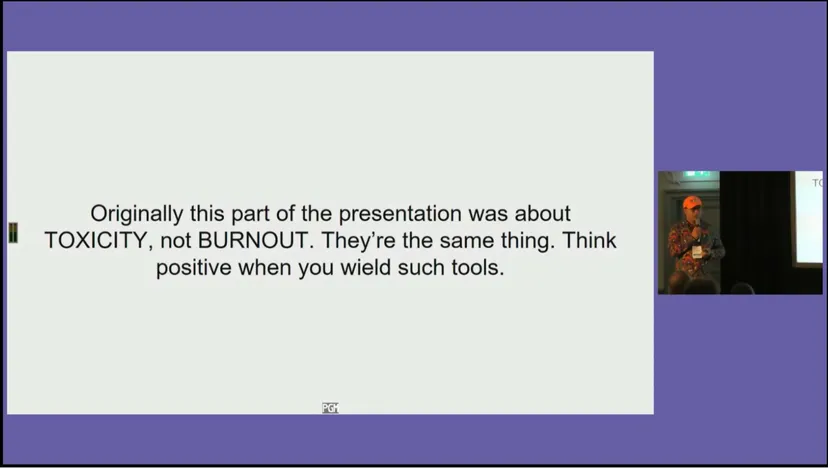

Tossicità e stanchezza? Il capo di Tinybuild afferma che sono “la stessa cosa”

In particolare, Nichiporchik suggerisce anche che lo strumento AI potrebbe essere utilizzato per identificare i “giocatori problematici della squadra” e confrontarli con i “giocatori A” cercando quelli che parlano molto nelle riunioni o che digitano molto. Chiama questi dipendenti “vampiri del tempo”, perché dal suo punto di vista sono essenzialmente perditempo, e osserva “Una volta che quella persona non è con l’azienda o il team, l’incontro dura 20 minuti e ne arriviamo cinque volte di più. “

A un certo punto, suggerisce Nichiporchik, l’intelligenza artificiale è stata utilizzata per identificare un leader dello studio che non era in una “buona posizione” e aiutarlo a evitare il burnout. In apparenza, questa potrebbe sembrare una vittoria, ma il CEO prosegue suggerendo che “le persone tossiche di solito sono persone oberate di lavoro”, aggiungendo: “Sono la stessa cosa”.

Immagine tramite Why Now Gaming / Develop

Equiparare la tossicità al burnout è nella migliore delle ipotesi fuorviante, ma ancora più preoccupante è il fatto che, all’inizio della conversazione, Nichiporchik ha parlato di rimuovere giocatori discutibili dall’azienda per aumentare la produttività. In questo caso, ciò apparentemente includerebbe coloro che soffrono di burnout.

Alla fine del suo discorso, Nichiporchik ha affermato che le aziende dovrebbero cercare di utilizzare gli strumenti di intelligenza artificiale in modo positivo ed evitare di far sentire i lavoratori “come se fossero spiati”. È un consiglio formulato con cura che potrebbe essere possibile spiare i tuoi dipendenti, ma solo se non permetti loro di “sentirsi” come se fossero spiati.

Game Developer ha contattato Tinybuild per ulteriori informazioni su come utilizza l’IA sul posto di lavoro.

Aggiornamento (14/07/23): Rispondi alla storia originale di Why Not Gaming su TwitterNichiporchik afferma che alcune delle diapositive della sua presentazione sono state estrapolate dal contesto e suggerisce che l’uso dell’intelligenza artificiale sul posto di lavoro “non riguarda l’identificazione dei dipendenti problematici”, ma piuttosto “fornire strumenti per le risorse umane per identificare e prevenire il burnout delle persone”.

Nichiporchik indica quindi un’altra diapositiva presente nella presentazione, in cui si afferma: “Il 99 percento delle volte in cui identifichi il burnout, è già troppo tardi”. Nota inoltre che la diapositiva del titolo per la sezione “AI for HR” è stata sostituita con una nuova che dice “AI per prevenire il burnout”, che descrive come “più sottile”.

“L’etica di tali processi è certamente discutibile e questa domanda è stata sollevata durante la sessione di domande e risposte dopo la presentazione”, continua Nichiporchik, sottolineando la comprensione che indirizzare le chiacchiere dei dipendenti a uno strumento di intelligenza artificiale nel tentativo di valutare le prestazioni e lo stato mentale dei lavoratori è eticamente discutibile… “Ecco perché dico ‘area dello specchio troppo nera’. Quella parte era ipotetica. Cosa puoi fare per prevenire il burnout.”

Il CEO ha chiuso il suo thread su Twitter chiedendo feedback ai partecipanti di Develop: Brighton che hanno guardato la presentazione in un “contesto completo”.

Ha detto, prima di affermare che la copertura di Why Now Gaming proviene da “un luogo di odio”:

aggiornare (14/07/23): In una risposta separata inviata direttamente a Why Now Gaming, Nichiporchik ha affermato che il dipartimento delle risorse umane della sua presentazione era semplicemente “virtuale” e che Tinybuild non utilizza strumenti di intelligenza artificiale per monitorare i dipendenti.

La dichiarazione recita: “La parte delle risorse umane della mia presentazione era ipotetica, da qui il riferimento a Black Mirror. Avrei potuto renderlo più chiaro guardando fuori dal contesto”. “Non monitoriamo i dipendenti né utilizziamo l’intelligenza artificiale per identificare i problemi. La presentazione ha esplorato come possono essere utilizzati gli strumenti di intelligenza artificiale e alcuni di loro entrano in un territorio spaventoso. Volevo esplorare come possono essere utilizzati per sempre”.

“Esploratore. Scrittore appassionato. Appassionato di Twitter. Organizzatore. Amico degli animali ovunque.”