Il consumo energetico giornaliero di alcuni modelli di intelligenza artificiale è attualmente misurato in megawattora. Si prevede infatti che nel prossimo futuro i numeri aumenteranno fino al punto di eguagliare i consumi nazionali di alcuni paesi. Lo rivela un nuovo studio incentrato sull’impronta energetica di queste nuove tecnologie.

Nel settore tecnologico, i data center sono sempre stati caratterizzati da un elevato consumo energetico. Di fronte a questa realtà, sono emerse soluzioni per migliorare l’efficienza energetica, come l’adozione di soluzioni di raffreddamento naturale o il recupero del calore residuo dai server. Ma che dire dell’intelligenza artificiale, questa tecnologia che ha contraddistinto il mondo negli ultimi anni?

Alex de Vries, dottorando e fondatore di una società di ricerca focalizzata sulle implicazioni delle tendenze digitali, ha esplorato questa domanda. Il suo studio è stato pubblicato sulla rivista

Jules, rivela dati inquietanti. I sistemi di intelligenza artificiale, in particolare i modelli linguistici di grandi dimensioni (LLM), consumano un’enorme quantità di energia. Se questa tendenza continua, il loro consumo potrebbe, nel prossimo futuro, rivaleggiare con quello di un intero Paese.

Fino a 564 MWh di elettricità al giorno per ChatGPT…

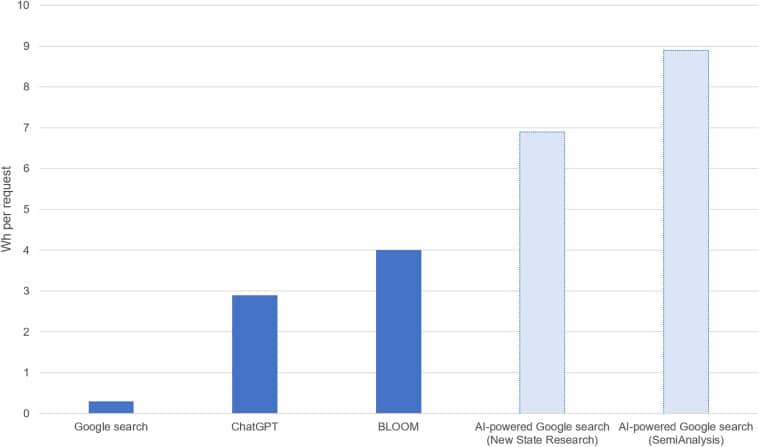

Proprio come una semplice ricerca su un motore di ricerca consuma energia, anche le interazioni con l’intelligenza artificiale generativa hanno un costo energetico. La differenza è che, secondo lo studio, quest’ultimo consumerebbe fino a 10 volte più energia. Nel caso di GPT, il modello linguistico utilizzato dal chatbot di OpenAI, una singola richiesta richiede 2,9 wattora di potenza. In base al numero di richieste presentate quotidianamente all’inizio dell’anno, lo studio stima che ChatGPT potrebbe consumare fino a 564 megawattora al giorno. Per contestualizzare, questa quantità di energia corrisponde al consumo medio annuo di 52 famiglie americane.

Consumo energetico stimato per query per vari sistemi basati sull’intelligenza artificiale rispetto a una ricerca Google standard. ©Alex de Vries

Oltre a interagire con gli utenti, i LLM consumano molte energie in particolare durante la fase formativa. Durante questa fase cruciale, questi modelli eseguono molti calcoli che richiedono un’enorme quantità di energia. A ciò si aggiunge anche l’energia necessaria per elaborare l’enorme volume di dati generati dal processo. Questi sono solo esempi che illustrano l’elevato costo energetico dell’intelligenza artificiale. Per ChatGPT-3 sarebbero stati necessari più di 1,2 TWh di potenza per l’allenamento. Altri LLM come Gopher e OPT (Open Pre-Trained Transformers) avrebbero consumato rispettivamente 1 TWh e 324 MWh.

Consumi presto equivalenti a quelli di un Paese?

Secondo lo studio, entro il 2027, il consumo energetico associato all’intelligenza artificiale potrebbe eguagliare quello di alcuni paesi come Paesi Bassi, Argentina, Svezia o Irlanda. Le proiezioni indicano un consumo compreso tra 85 e 134 TWh all’anno. Il motivo alla base delle previsioni dell’autore dello studio per il 2027 è che si aspetta che le attuali sfide della catena di approvvigionamento vengano risolte. Attualmente, l’offerta di server IA si trova ad affrontare un collo di bottiglia, con la domanda che supera di gran lunga l’offerta disponibile. Inoltre, Alex de Vries prevede un aumento dell’adozione dell’intelligenza artificiale. In effetti, le tecnologie si stanno evolvendo rapidamente, con l’emergere regolarmente di versioni più efficienti ed efficaci, per non parlare del numero crescente di aziende che desiderano integrare l’intelligenza artificiale nelle proprie operazioni.

L’intelligenza artificiale è già stata al centro di molte controversie, sia che si tratti dell’uso dei dati senza consenso o della possibilità che le macchine possano sostituire i professionisti, solo per citarne alcune. Qui sorge una domanda: questo aumento del consumo di energia verrà aggiunto all’elenco delle principali preoccupazioni associate all’intelligenza artificiale?

fonte : Jules

“Pioniere del caffè a misura di hipster. Creatore amichevole. Analista pluripremiato. Scrittore. Studioso di cibo. Drogato di televisione. Ninja di Internet.”